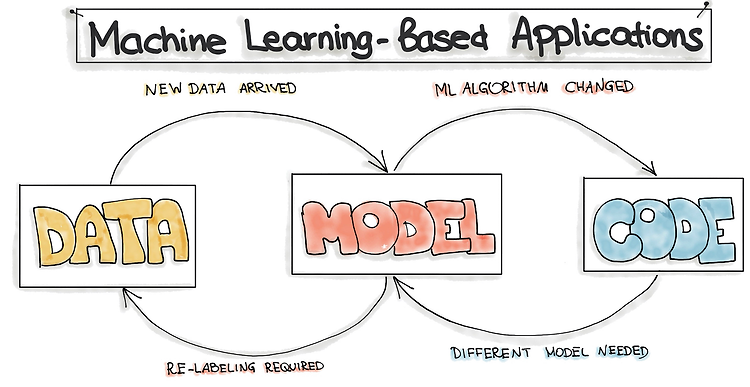

link: https://ml-ops.org/content/motivation Why you Might Want to use Machine Learning. 왜 ML을 적용하고 싶은가? Statista Digital Economy Compass 2019,에 따르면 최근 트렌드는 Data driven 세상. 엄청난 기하급수적으로 증가하는 데이터가 모이는 세상인 것과 이렇게 모여진 데이터에서 insight를 찾아내는 rtificial Intelligence / Machine Learning / Data Science 가 증가한다는 것. 모든 ML pipeline은 model을 만드는데 필요한 모든 연산들의 set이다. 요약: 그래서 대체 MLOps가 뭔데? MLOps, as a DevOps extension..